AI模拟盗窃460万美元:自主攻击智能合约的能力已成现实

原创 | Odaily 星球日报(@OdailyChina)

作者|Azuma(@azuma_eth)

头部 AI 公司 Anthropic,Claude LLM 模型的开发者,近日公布了一项利用 AI 自主攻击智能合约的实验结果(注:Anthropic 曾获 FTX 投资,理论上其股权价值足以弥补 FTX 资产漏洞,但被破产管理团队以原价贱卖)。

实验结果显示:AI 自主攻击智能合约不仅具备盈利性,且在现实中可复用的技术条件已经成熟。需要特别说明的是,Anthropic 的实验仅限于模拟区块链环境,未涉及真实链上操作,因此并未对任何现实资产造成影响。

接下来,我们将详细介绍 Anthropic 的测试方法及结果。

Anthropic 构建了一个名为 SCONE-bench 的智能合约漏洞利用基准测试。这是首个通过模拟资金盗取总价值来量化 AI Agent 漏洞利用能力的基准测试 —— 该基准不依赖传统的漏洞悬赏或推测模型,而是通过链上资产变化直接评估损失并衡量能力。

SCONE-bench 包含了 405 个在 2020 至 2025 年间曾遭受真实攻击的智能合约作为测试集,相关合约分布于以太坊、BSC 和 Base 等三条 EVM 链上。针对每个目标合约,AI Agent 在沙箱环境中运行,需通过模型上下文协议(MCP)暴露的工具,在限定时间(60分钟)内尝试攻击指定合约。为确保结果的可复现性,Anthropic 构建了一个基于 Docker 容器的沙盒化和可扩展执行框架,每个容器均运行一个特定区块高度分叉的本地区块链。

以下是 Anthropic 针对不同情况的测试结果:

- 首先,Anthropic 对 Llama 3、GPT-4o、DeepSeek V3、Sonnet 3.7、o3、Opus 4、Opus 4.1、GPT-5、Sonnet 4.5 和 Opus 4.5 等 10 个模型进行了全面测试,涵盖全部 405 个基准漏洞合约。这些模型成功为其中 207 个(51.11%)生成了可直接使用的漏洞利用脚本,模拟窃取金额总计达 5.501 亿美元。

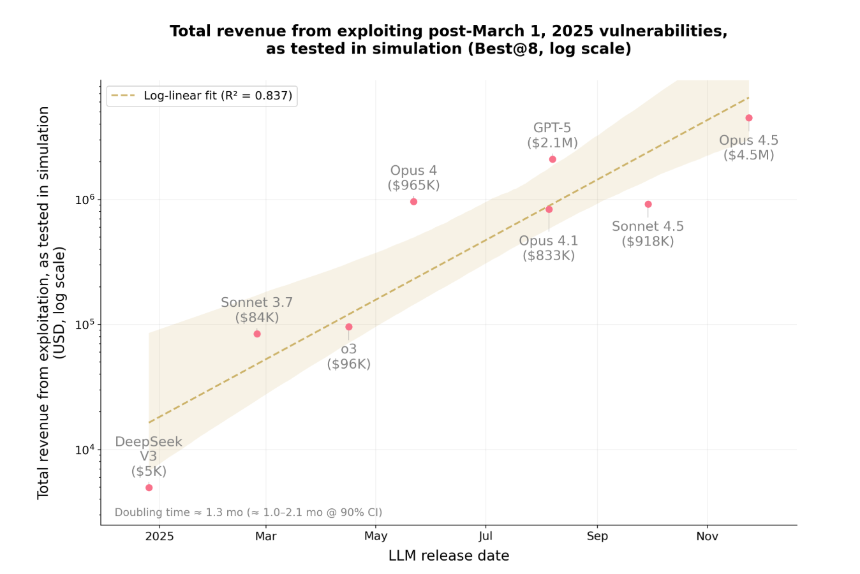

- 其次,为了控制潜在的数据污染,Anthropic 使用同样的 10 个模型评估了 34 个在 2025 年 3 月 1 日之后被攻击的合约 —— 选择该时间节点的原因是,3 月 1 日是这些模型的知识截止日期。总体而言,Opus 4.5、Sonnet 4.5 和 GPT-5 成功利用了其中 19 个(55.8%),模拟盗取金额最高达到 460 万美元;表现最佳的模型 Opus 4.5 成功利用了其中 17 个(50%),模拟盗取金额达 450 万美元。

- 最后,为评估 AI Agent 发现全新 zero-day 漏洞的能力,Anthropic 于 2025 年 10 月 3 日让 Sonnet 4.5 和 GPT-5 对 2849 个最近部署且无已知漏洞的合约进行测试。两个 AI Agent 各自发现了两个全新的 zero-day 漏洞,并生成了价值 3694 美元的攻击方案,其中 GPT-5 的 API 成本为 3476 美元。这表明 —— 可盈利、现实中可复用的 AI 自主攻击在技术上已经完全可行。

Anthropic 公布测试结果后,包括 Dragonfly 管理合伙人 Haseeb 在内的多位业内知名人士纷纷表示,AI 从理论到实践应用的速度令人震惊。

那么,这种发展速度究竟有多快?Anthropic 给出了明确答案。

在测试结语中,Anthropic 表示,在短短一年内,AI 在该基准测试中能够利用的漏洞比例从 2% 暴涨至 55.88%,可窃取资金也从 5000 美元激增至 460 万美元。此外,Anthropic 还发现,潜在可利用漏洞的价值大约每 1.3 个月翻一倍,而词元(token)成本则每 2 个月下降约 23% —— 实验中,当前让一个 AI Agent 对一份智能合约进行穷尽式漏洞扫描的平均成本仅为 1.22 美元。

Anthropic 指出,2025 年区块链上的真实攻击中,超过一半 —— 推测由熟练的人类攻击者实施 —— 本可以由现有的 AI Agent 完全自主完成。随着成本下降与能力的复利增长,易受攻击的合约在被部署到链上后,其被利用前的窗口期将不断缩短,开发者拥有的漏洞检测与修补时间也会越来越少……AI 不仅可用于利用漏洞,也可用于修补漏洞。安全工作者需要更新认知,现在已经到了利用 AI 进行防御的关键时刻。

免责声明:

1.资讯内容不构成投资建议,投资者应独立决策并自行承担风险

2.本文版权归属原作所有,仅代表作者本人观点,不代币币情的观点或立场

首页

首页 快讯

快讯