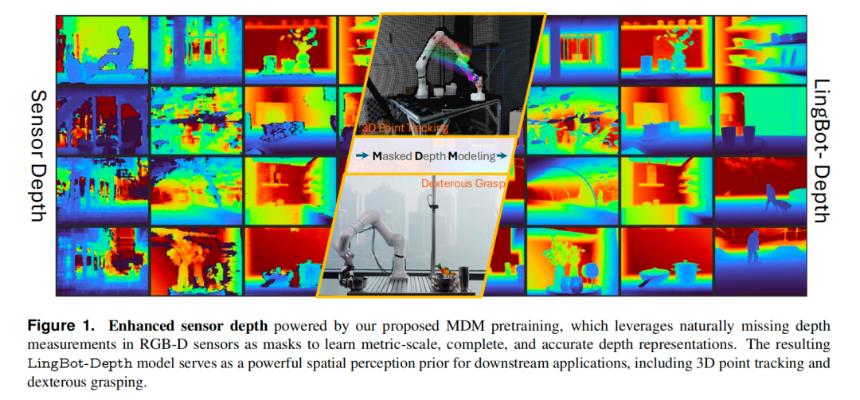

蚂蚁灵波开源LingBot-Depth:机器人深度视觉难题迎刃而解

透明和反光物体一直是机器人视觉感知中的“老大难”问题。无论是玻璃门还是不锈钢杯,这些材质都会让传统深度相机“失明”,从而阻碍了机器人在家庭、商场等场景中的广泛应用。

然而,这一长期困扰行业的问题如今迎来了突破性进展——蚂蚁集团旗下的具身智能公司蚂蚁灵波(RobbyAnt)开源了全球领先的深度视觉模型LingBot-Depth。

LingBot-Depth不仅解决了透明与反光物体的深度感知难题,还无需更换现有硬件即可显著提升机器人对复杂环境的感知能力。这一技术突破为机器人走进更多实际应用场景铺平了道路。

透明与反光:两个截然不同的问题

在算法层面,透明和反光物体的问题本质上是两类截然不同甚至相反的挑战:

- 透明物体:信息缺失。玻璃几乎不提供稳定的纹理或反射,传感器接收到的往往是背景的延续。

- 反光物体:信息过载。高反射率表面会将环境、光源甚至相机本身映射进画面,导致同一物体在不同角度下呈现完全不同的外观。

针对这些问题,LingBot-Depth采用了一种全新的方法论,明确区分透明与反光的物理成因,并将其作为特征而非噪声加以利用。

核心技术:Masked Depth Modeling (MDM)

LingBot-Depth的核心创新在于提出了一种名为Masked Depth Modeling (MDM) 的全新范式。其核心思想是将传感器天然产生的缺失区域视为一种“掩码”,并要求模型通过RGB图像和剩余有效深度信息来补全这些缺失部分。

具体而言,该模型采用了以下关键技术:

- 联合嵌入ViT架构:使用视觉Transformer(ViT-Large)处理RGB图像和深度图,生成跨模态的联合表征。

- 智能掩码策略:优先使用传感器天然缺失区域作为掩码,并结合随机掩码以增强鲁棒性。

- ConvStack解码器:采用卷积金字塔解码器,在重建阶段保留空间细节和边界锐度。

通过这种方式,LingBot-Depth不仅能补全深度信息,还能从单目RGB图像中估算出准确的深度图,展现出强大的泛化能力。

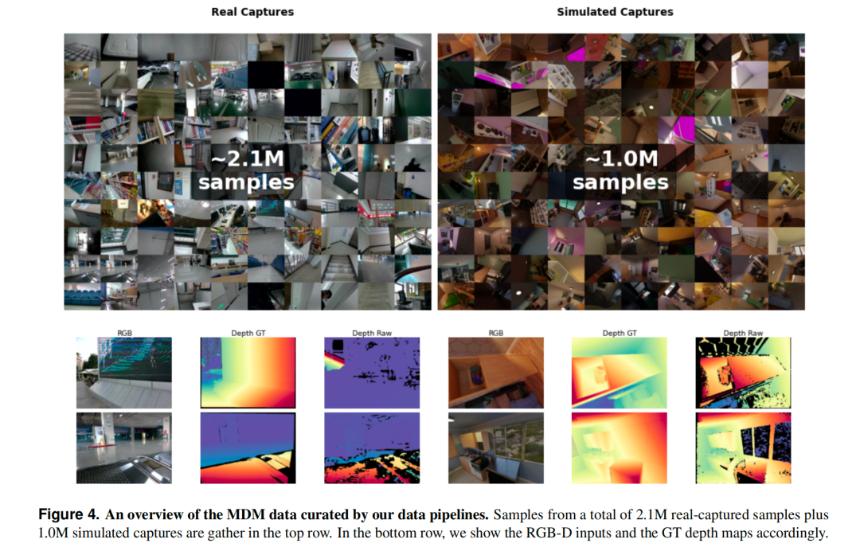

数据驱动:200万真实数据+100万仿真数据

高质量的数据是模型性能的基础。蚂蚁灵波团队构建了一套可扩展的数据采集与合成pipeline,最终汇集了总计约300万的高质量RGB-D样本用于预训练。

- 真实数据:覆盖住宅、办公室、商场等多种场景,包含大量透明、反光及低纹理物体。

- 仿真数据:通过Blender渲染RGB图像和带散斑的红外立体图像对,模拟真实传感器的失效模式。

得益于庞大的数据集,LingBot-Depth在多个权威基准测试中全面超越当前最先进的SOTA方法,尤其是在极端设定下表现尤为突出。

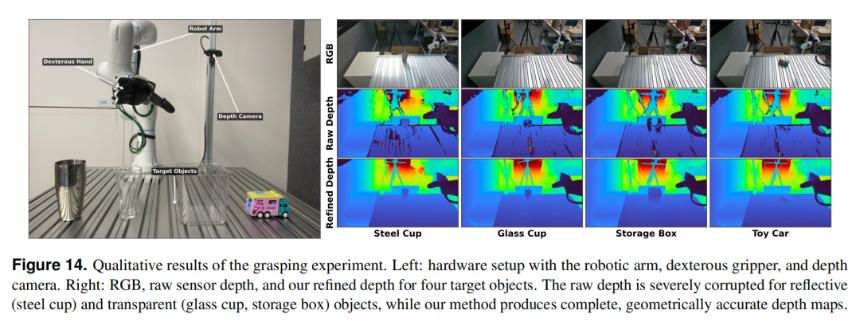

实际应用:赋能机器人抓取透明与反光物体

为了验证LingBot-Depth在真实世界中的价值,蚂蚁灵波团队将其部署到一台机械臂平台上进行实验。实验目标包括抓取不锈钢杯、透明玻璃杯、透明收纳盒等极具挑战性的物体。

结果显示,在20次抓取尝试中,使用LingBot-Depth的成功率远高于仅依赖原始深度数据的方法。

软硬协同:低成本实现高性能感知

LingBot-Depth的最大亮点之一在于它无需更换现有硬件即可显著提升感知效果。这种软硬协同的方式大幅降低了成本,加速了机器人在家庭服务、仓储物流等场景中的落地进程。

此外,蚂蚁灵波团队秉承开放精神,已开源LingBot-Depth的代码、模型权重以及庞大的300万RGB-D数据集,为学术界和工业界的研究提供了重要支持。

本文来源:

免责声明:

1.资讯内容不构成投资建议,投资者应独立决策并自行承担风险

2.本文版权归属原作所有,仅代表作者本人观点,不代币币情的观点或立场

首页

首页 快讯

快讯