深度解析:为何DeepSeek-R1的“幻觉”问题如此突出?

来源:腾讯科技

DeepSeek系列模型在许多领域表现出色,但其“幻觉”问题仍然是一个显著挑战。

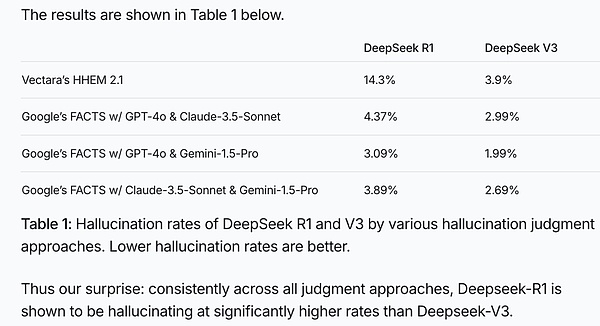

在Vectara HHEM人工智能幻觉测试中,DeepSeek-R1显示出14.3%的幻觉率。

图:Vectara HHEM人工智能幻觉测试结果

显然,DeepSeek-R1的幻觉率不仅是DeepSeek-V3的近4倍,也远超行业平均水平。

在博主Levy Rozman组织的一次娱乐性对弈中,DeepSeek-R1展现出较高的“作弊”频率:

比如,在国际象棋对局中,DeepSeek-R1主动送小兵给对手;后期还声称规则更新,用小兵吃掉了ChatGPT的皇后,并最终说服ChatGPT认输。

虽然这只是娱乐视频,但也揭示了大模型容易一本正经地“胡说八道”的特性。

对于人类而言,大模型的幻觉问题如同悬在AI发展之路上的达摩克利斯之剑。以下是一些值得深思的问题:

-

大模型为何会产生幻觉,这是缺陷还是优点?

-

当DeepSeek-R1展现惊人创造力时,其幻觉问题有多严重?

-

大模型幻觉主要出现在哪些领域?

-

如何让大模型既有创造力又少出幻觉?

腾讯科技特邀出门问问大模型团队前工程副总裁李维博士,深入探讨与大模型幻觉相关的问题:

图:李维 出门问问大模型团队前工程副总裁、Netbase前首席科学家

1. 大模型为什么会“产生幻觉”?

大模型像一个“超级接话茬儿高手”,根据学过的知识预测接下来的内容。由于信息压缩和泛化,它可能会“脑补”不存在的事实。

例如,问“姚明有多高”时,模型能准确回答;但问“隔壁老王有多高”时,它可能编造一个答案。

幻觉的本质是补白,是在事实冗余度不足的情况下进行的合理猜测。

某种程度上,幻觉就是想象力,也是创意!正如赫拉利所说,人类通过“讲故事”创造了文明。

2. DeepSeek-R1的幻觉问题到底有多严重?

根据Vectara的测试,R1的幻觉率显著高于V3,达到14.3%。这与其强化的“思维链”(CoT)和创造力密切相关。

具体原因包括:

首先,摘要任务本已成熟,过度强化可能导致反效果。

其次,R1的长思维链未针对简单任务优化,增加了复杂性和幻觉。

此外,文科类任务训练中可能更注重创造性,导致偏离事实。

3. 大模型幻觉主要出现在哪些领域?

R1在数学和代码等“理科”领域逻辑性强,幻觉较少;但在语言创作领域,尤其是摘要任务中,幻觉问题明显。

推理能力增强与幻觉之间并非简单的正负相关关系。

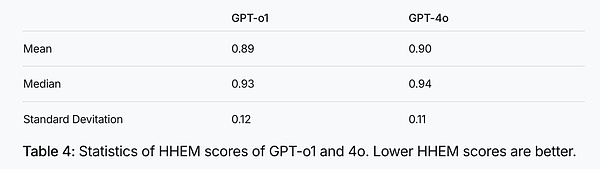

图:GPT-o1和4o的HHEM分数统计,HHEM分数越低幻觉越低

比起基座模型,o1降低了幻觉,而R1增加了幻觉,可能是文科思维链用力过猛。

4. 如何让大模型既有创造力又少出幻觉?

保持警惕:对涉及事实的内容需特别小心。

交叉验证:重要细节可上网查证或咨询专家。

引导模型:提问时加限定条件,如“请务必忠于原文”。

Search(联网搜索):利用RAG技术减少幻觉。

享受创意:将幻觉视为“平行世界的可能性”。

未来可通过更精细的训练和Routing机制来平衡创造力与忠实性。

免责声明:

1.资讯内容不构成投资建议,投资者应独立决策并自行承担风险

2.本文版权归属原作所有,仅代表作者本人观点,不代币币情的观点或立场

首页

首页 快讯

快讯